新课

在 deeplearning.ai 上看到吴恩达(Andrew Ng)老师又开了新课,我非常开心。这门课程名称叫做 Generative AI for Everyone (面向所有人的生成式人工智能),链接在这里。

目前课程一次性上线了三周的学习资料。

我最近比较忙,刚学完了第一周的课程,但是已经有了不少感悟和收获。今天就来跟你分享一下,这门课对我产生的影响。

这里说一下我记录的原则。少楠的新书《笔记的方法》里面提到的,笔记应当记录那些让你感到「有启发」的内容,而不是全部记录。我非常了解的内容,尽管吴恩达教授讲得非常好,也没有出现在这篇文章里。我们每个人都有自己的知识背景,所以我建议你能够自己认真学习这个课程,从中找到对你自己「有启发」的部分,并且也做好记录,以应用在将来的工作和学习中。

讲授

之前吴恩达老师在 deeplearning.ai 平台上已经与各种机构 —— 例如 LangChain,OpenAI 等等 —— 合作开发了一系列短课程,我都已经推荐给了学生和读者。

尽管这些课程讲的内容非常新颖,内容也很有价值,但多是对方主讲。其讲授方法和吴恩达教授比起来,差得太远了。

吴恩达老师的讲课方式,我想用两个词来总结——清晰和生动。

先说清晰。

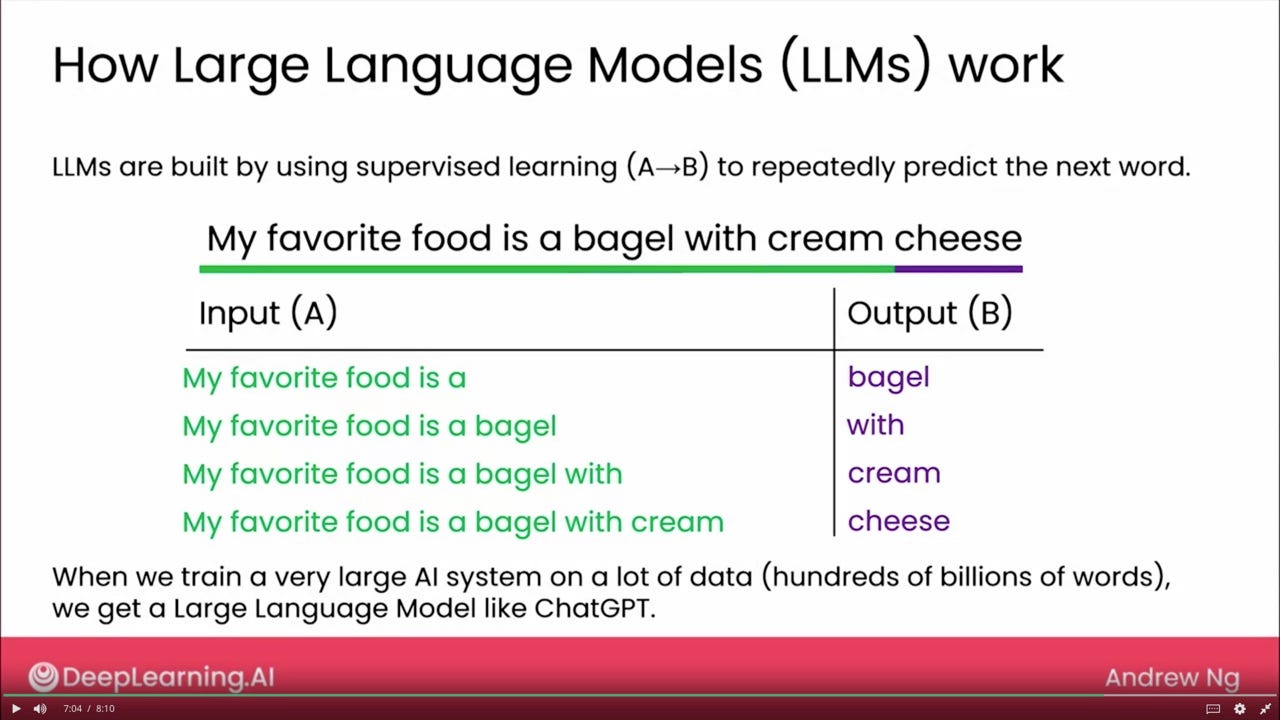

下面是视频里出现的一张幻灯,讲大语言模型训练中自监督学习阶段的例子。

以前我在上课或讲座时经常提到「自监督学习」,并尝试举例来说明 LLM 是如何被训练「预测下一个词儿」的。但一对比就会发现,只需要拿出这样一句话的例子,逐步迭代说明 Input (A) 和 Output (B) 的对应变化,观众立即就能弄懂「自监督」的概念了。比起大段语言描述,这种例证的方式要直观和清晰许多。

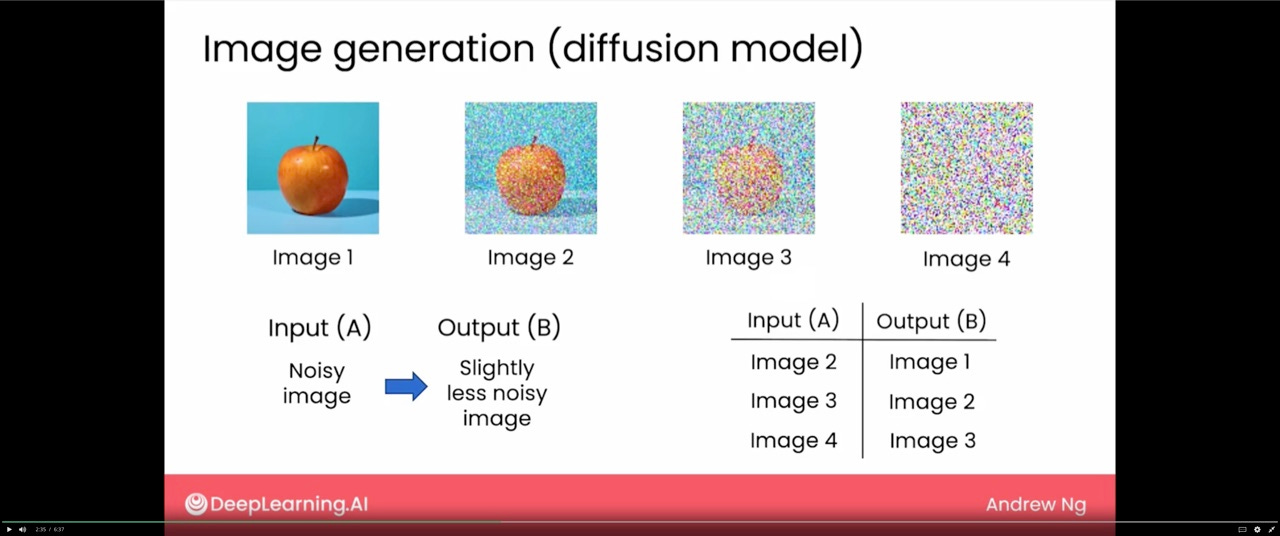

再比如第一周的末尾,吴恩达老师讲了 Stable Diffusion 生成式绘图的原理。

我之前从各种教程上也都看过类似的讲解。各位主讲老师介绍方式也很生动,包括这些图片不断加入噪声的过程,有的还做成了动画。只不过,这里同样就是加上了个 Input(A) 和 Output(B) ,对照着上面的图片,不断渐进出现,你立刻就能明白同样的模型如何对每一步,都能逐步推测更为清晰图像的过程。在我看来,能够用最简短的语言和直接的方式传递知识,就叫做「清晰」。

下面聊聊「生动」。吴恩达老师讲解的方式风趣幽默,用例非常吸引人。

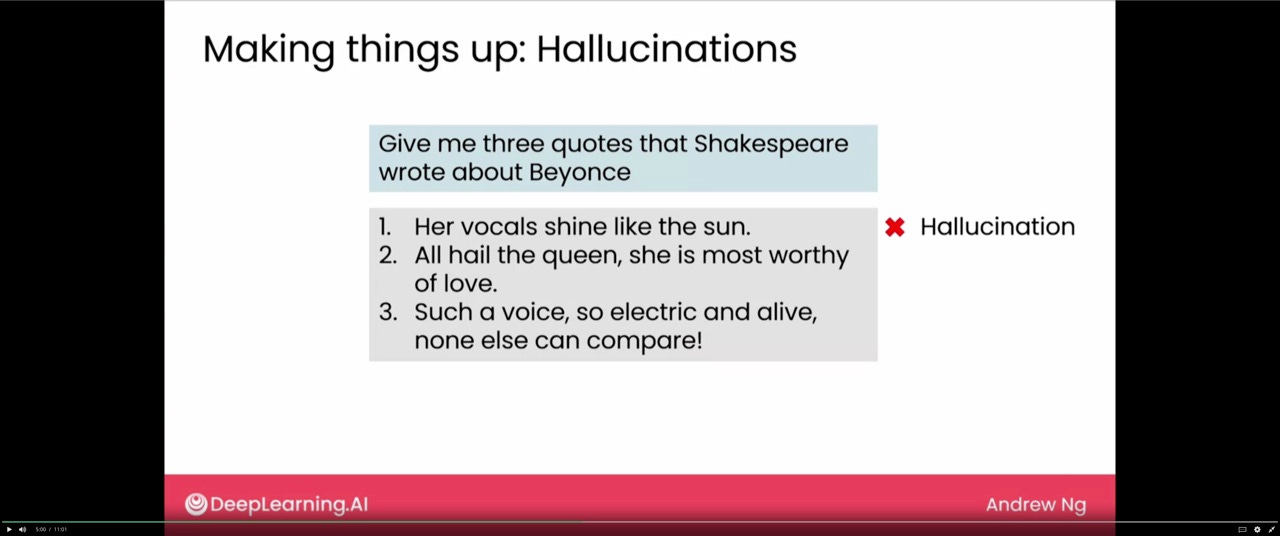

例如提到大语言模型的「幻觉」(Hallucinations),吴恩达老师提到 LLM 如何编造答案来取悦用户。

这里的例子就很有趣,他问莎士比亚的哪些诗提到了碧昂丝(Beyonce)。这简直就是西方版的「关公战秦琼」嘛,可是 LLM 真的就敢「顺杆儿爬」给你编造啊。

当然,幻觉带来的后果绝不仅仅是好玩儿,下面这个就很严重。

课件中提到,一个律师使用 ChatGPT 提供的答案,直接提交给法庭。后果如何?课程里面有,自己看吧。

内容

下面咱们谈谈课程的内容。我学过第一周后,感觉非常实用。

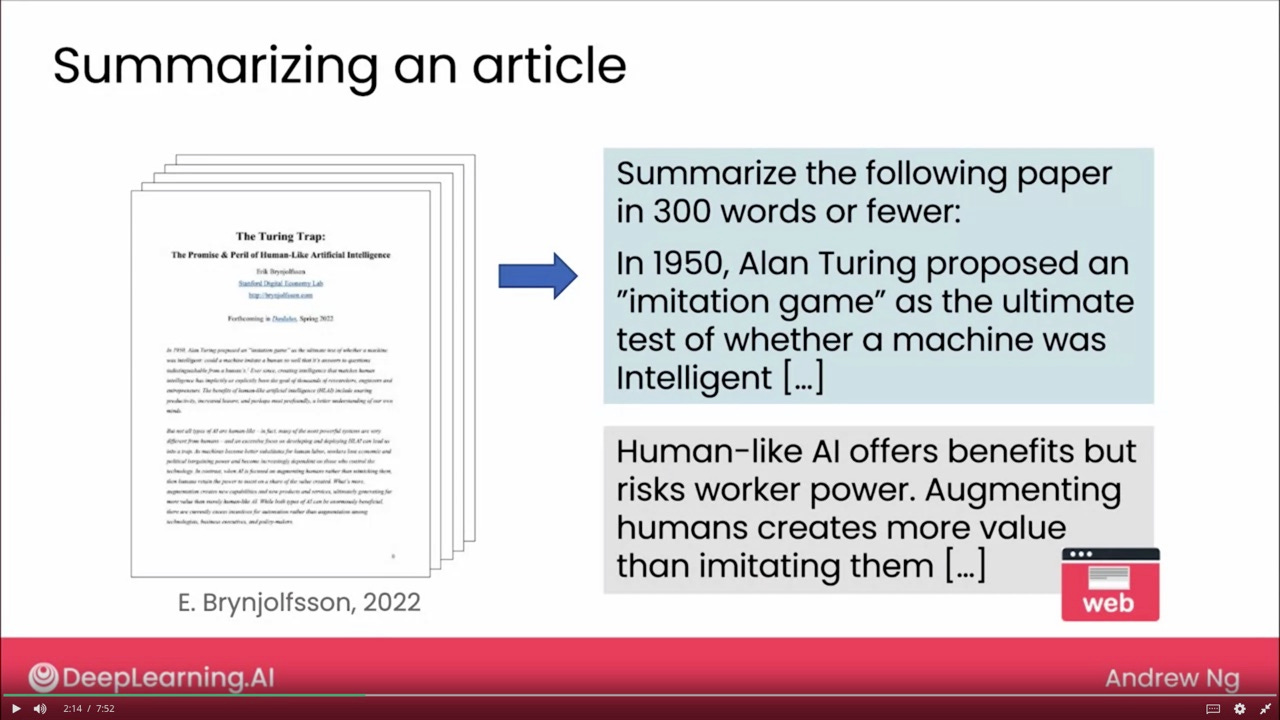

首先,吴恩达老师谈到了自己应用 LLM 的例子,包括但不限于阅读和写作。

我突然发现,连大师也不肯自己从头到尾读论文了,而是直接让ChatGPT负责总结成几百字的概要,哈哈。当然,最终吴老师还是圆了回来,说那确实是一篇好文章,自己后来也仔细看了。

看到这个例子,我突然想起之前很多人抱怨,在国外读书(尤其是文科)总是需要读大部头,然后总结成多少字,上课来讨论。自己读得慢,页数不够多,讨论就很尴尬。我于是就在想,有了 ChatGPT,还真的有人从头读到尾认真读书吗?

你读一个晚上,可能依然一头雾水。可是如果让 LLM 读,分分钟就能给出分析结果。至于应对课堂的讨论稿嘛,你想让它输出多少字就可以输出多少字啊。那以后上课,老师们可能是在看着一群 LLM 的「代理人」在切磋 —— 嗯,这个是 GPT-4 的 Agent,那个是 Claude 2 的……

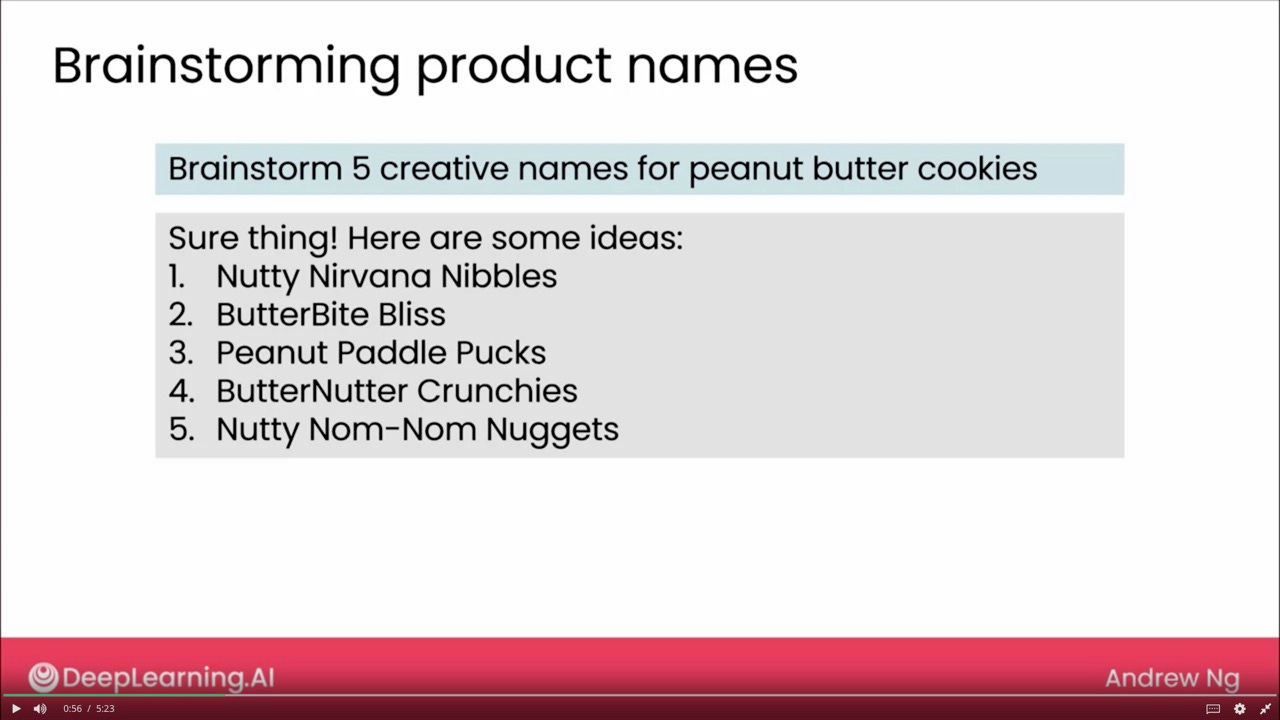

讲到写作,吴老师说自己经常让 ChatGPT 帮着做头脑风暴。

这两年,因为《卡片笔记写作法》一书的流行,「头脑风暴」一词在该书的拥趸中已经逐渐转化为略为负面的词汇。因为书中提出「头脑风暴」其实是压榨自己的头脑,产生的结果并不全面,还给写作带来不必要的压力。

压榨自己的脑袋,可能确实有问题。但压榨 LLM 呢?似乎从伦理上和心理上都不会有什么问题吧?况且它见多识广,不害怕用户去「压榨」。

讲完了个人应用,吴老师也讲了商业应用的样例。

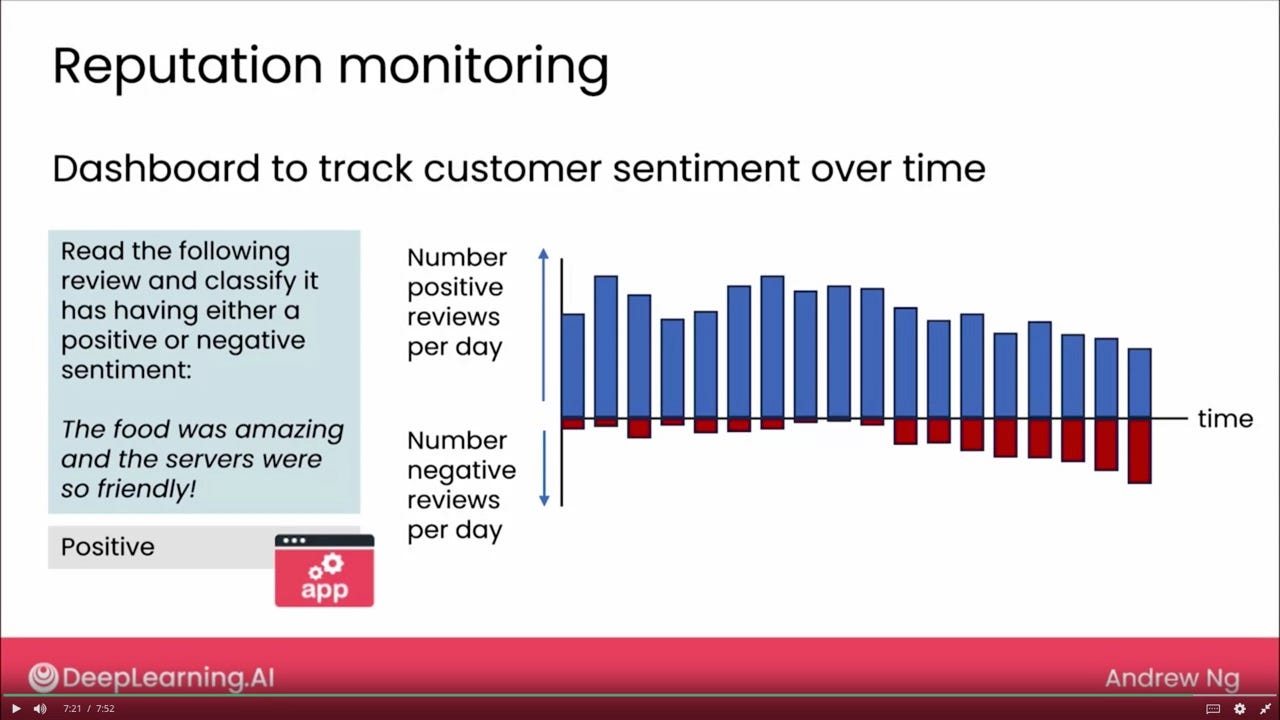

其中查看自己商铺、产品或服务评价这个用例,我本周课上刚刚给学生们介绍过。只不过,使用小模型,尚需足够样本在 BERT 或者 ULMfit 上进行微调;而使用 LLM ,你可以尝试无样本或者少样本学习,结果却可能更加精准。

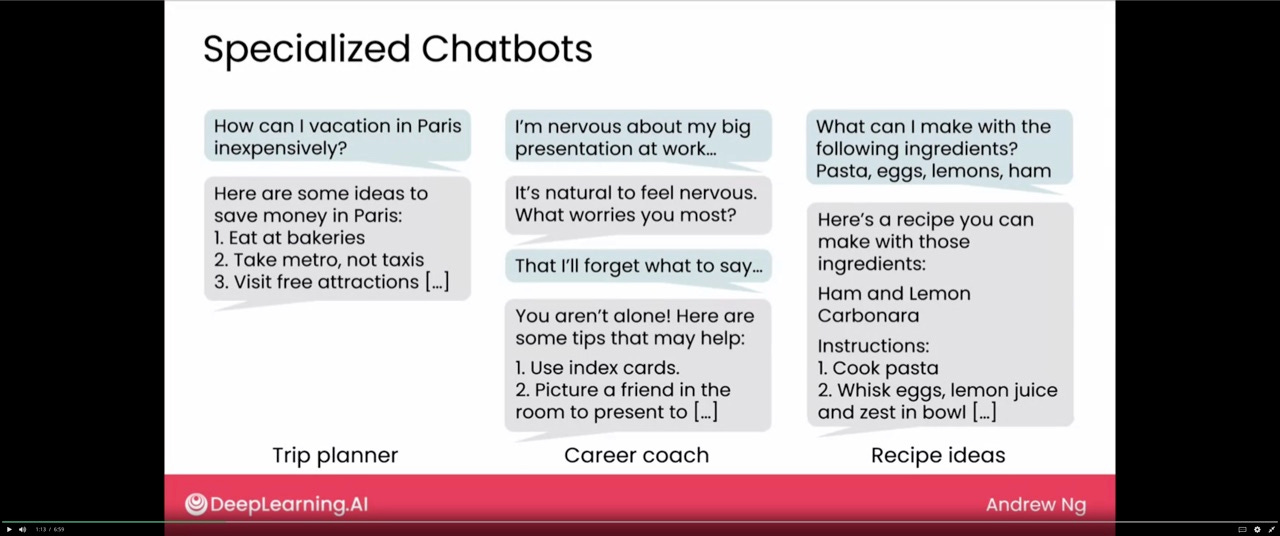

吴恩达老师提到的各种善解人意的 chatbot ,也给了我很多启发。特别是生涯教练这个,鼓励的话语让用户很振奋。

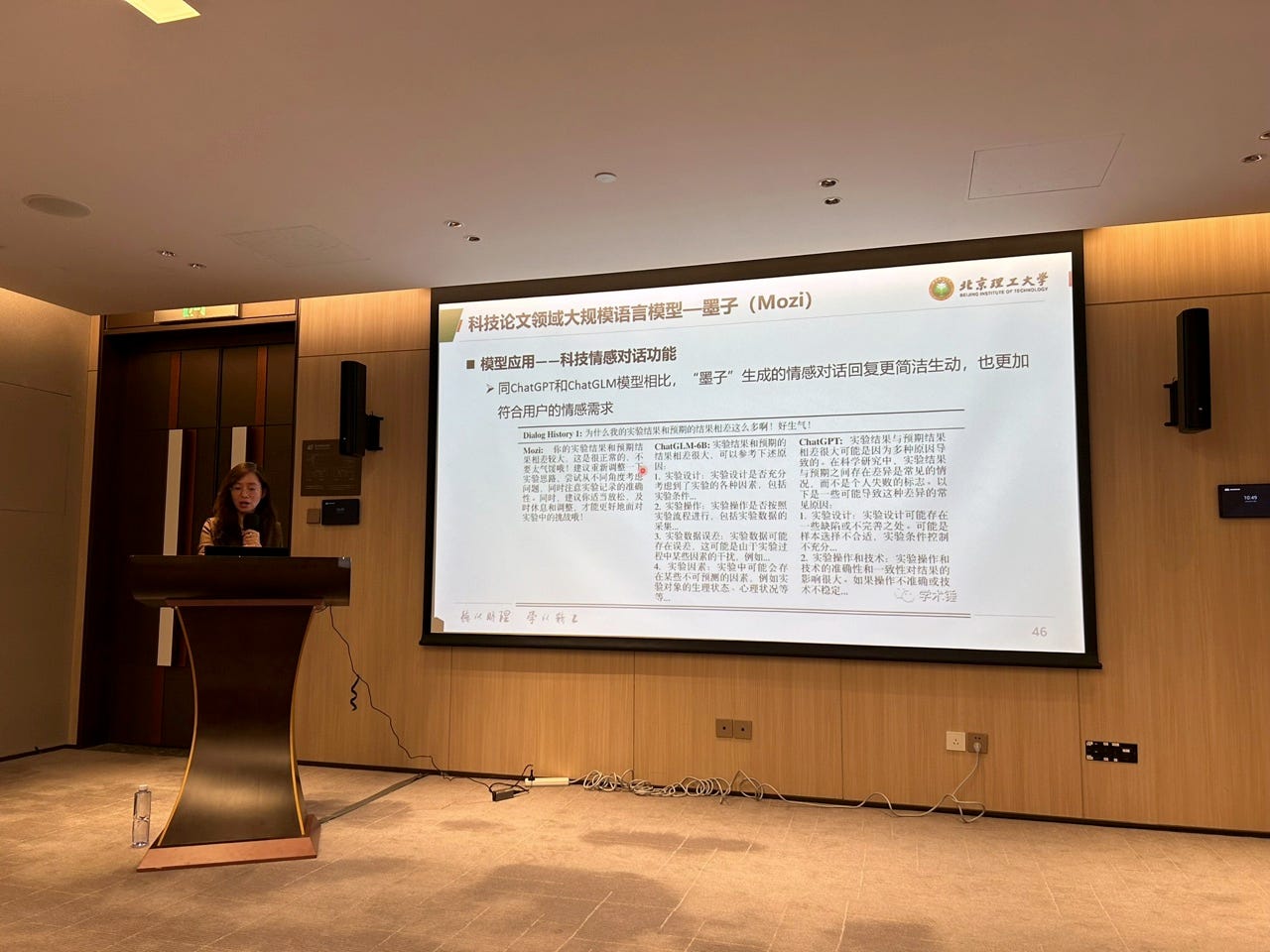

我突然想起来上周在雄安开会,孙新老师提到的那个提供情感辅助的 LLM ,可以帮助研究生应对科研中遇到的挫折,疏解压力、鼓劲儿,很有作用。

这里我不禁在想教育的意义。如果传道受业解惑被 LLM 替代了,老师们倒还可以强调教育「建立情感纽带」的功能;可如果连这种情感辅助都被 LLM 替代掉,教师的职业意义建构该怎么做呢?

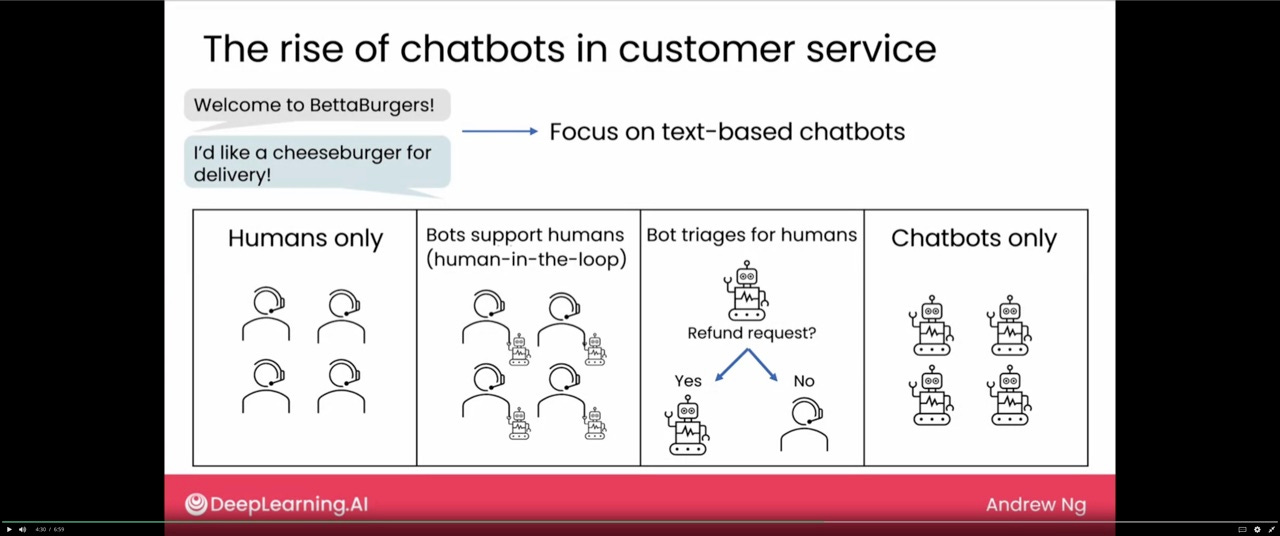

吴恩达老师课程中提到 chatbot 改变客服工作方式,触及到了我最感兴趣的一个问题 —— 人机究竟该如何配合?

两端的情况(纯人工或者纯机器)咱们就不说了,值得注意的是中间两种人机配合的方式。

中间左侧这个,明显是人类真的不放心。每一个对话,都需要人工在其中干预和决策。但是这种方式,深刻生动诠释了,什么叫做 “Human in the Loop”。我以前觉得,这就是人机协同的全部了,但是这张图充分说明了我原先考虑还不够周全。

中间右侧这个就是另外一种情况 —— 机器如果能解决,就全都是机器来做,否则才需要人工介入。其实,你可以把它当作一种机器能力足够高和人类信心特别强的体现。但细细思考,我们生活中反而更容易见到这种方式。

例如说,你有没有给电信运营商打过客服电话?你说它们提供的「人机协同」模式算哪个呢?这里 有一段视频,很好玩儿。读完本文你可以点开看看,就当个乐儿吧。

另外吴老师的内容讲授不止一次给我的感受,是「英雄所见略同」。不过请注意,这里的「英雄」说的不是我本人啊。

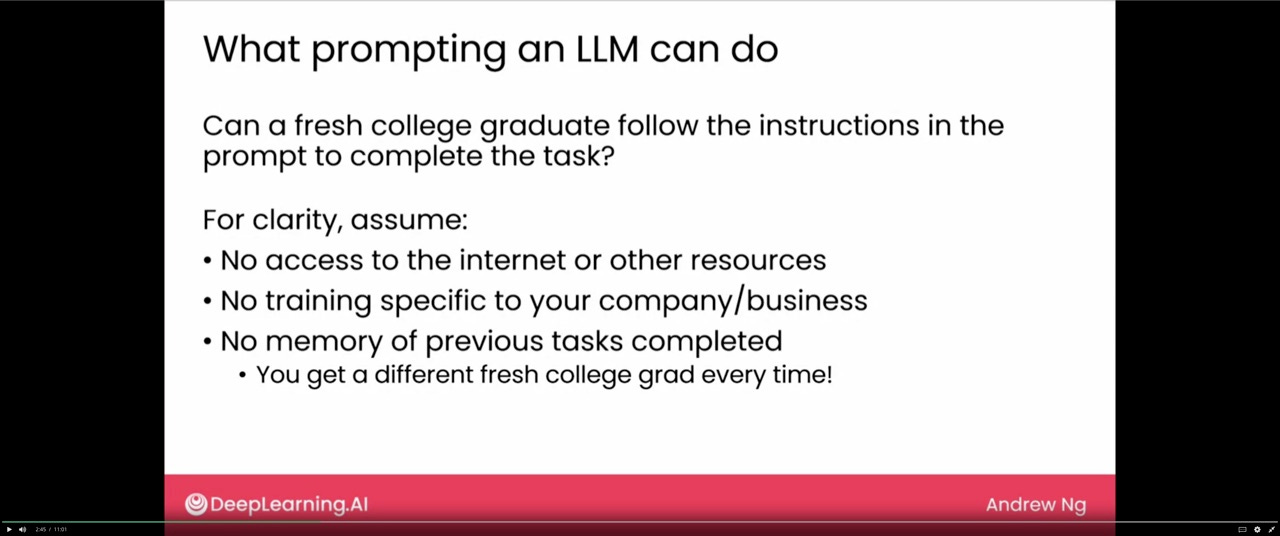

上面这张幻灯截图,用 GPT-4 (All Tools) 模式自动识别图片,翻译如下:

描述了使用大语言模型(LLM)时的提示(prompting)能做什么。图片中提到,如果给一个刚刚毕业的大学生一些指导,他们是否能够完成任务。为了更加清晰明了,假设情况如下:

没有互联网或其他资源的访问权限

对你的公司 / 业务没有特定的培训

没有完成先前任务的记忆

每次都会得到一个不同的新毕业的大学生

图片旨在探讨在没有额外资源和指导的情况下,一个新毕业的大学生是否能够根据给定的指导完成任务。

我一看到这个论述,就觉得眼熟。因为上次去北京参加开智大会,安替老师也指出,他们企业现在就是把 LLM 当成实习生用。实习生,不刚好就是幻灯中提到的这个年龄和学历阶段吗?你看,是不是英雄所见略同?

只是两位老师所谈论的内容,侧重点还是不同的。吴恩达老师讲的,是提示词应该如何设计,才能让 LLM 充分理解消化。而安替老师则是在说明 LLM 的能力边界与可扩展性。他主要强调的是,目前 AI 的水平也只能替掉实习生而,只不过一个 AI 就能替掉 100 个实习生,还任劳任怨。

学习方法

我总结自己学习本课程的有效方法包括以下两点:

Keep reading with a 7-day free trial

Subscribe to Shuyi’s Newsletter to keep reading this post and get 7 days of free access to the full post archives.